Mehr als nur Chatbots: Entdecken Sie die Macht von 'Chat With Your Docs' für Ihr Unternehmen

Inhaltsverzeichnis

Die Veröffentlichung von OpenAIs ChatGPT hat die Art und Weise, wie wir Informationen verarbeiten, revolutioniert. Noch nie war es einfacher, mit dem gesamten Wissen der Menschheit interaktiv, in natürlicher Sprache über ein simples Chat-Interface zu interagieren. Dies bietet für Unternehmen immense Potentiale. Von der einfachen Recherchearbeit, dem Zusammenfassen von Texten oder der Ideengenerierung für die nächste Marketingkampagne sind den Anwendungsfeldern keine Grenzen gesetzt.

Jedoch können konventionelle große Sprachmodelle - sogenannte Large Language Models (LLMs) - wie ChatGPT nur allgemeines Wissen abrufen und vermitteln, können also von Haus aus nicht auf unternehmensinternes Wissen zugreifen. Doch wie sieht es aus, wenn wir Sprachmodelle im Unternehmenskontext einsetzen wollen?

Die Lösung sind sogenannte “Chat With Your Docs”-Applikationen: Chatbots bzw. Large Language Model (LLM) Assistenten, die es ermöglichen, mit den unternehmenseigenen Daten zu interagieren.

Im Folgenden betrachten wir die Funktionsweise dieser Assistenten, diskutieren Anwendungsszenarien und was bei der Implementierung und Integration dieser Applikationen zu berücksichtigen ist.

Funktionsweise

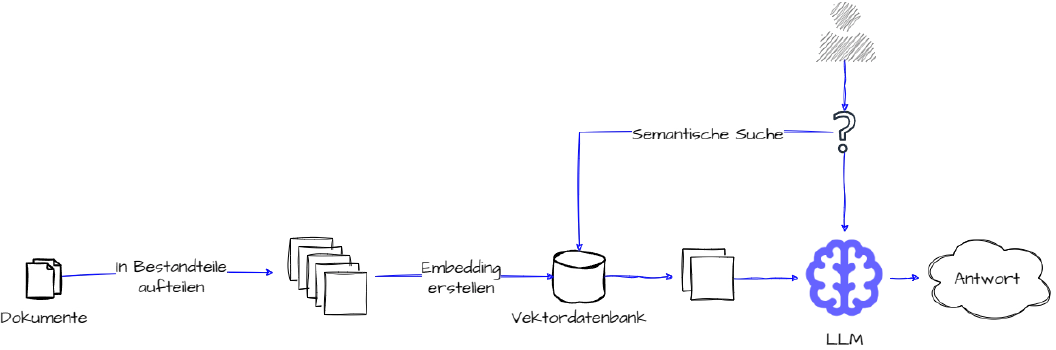

LLM Assistenten, die es ermöglichen mit unternehmenseigenen Daten zu interagieren, bestehen aus drei Komponenten: einem LLM, einem Datenspeicher und einer Vektordatenbank. Diese Komponenten ermöglichen im Zusammenspiel das Abrufen von relevanten Informationen aus externen Quellen und eine darauf basierende Generierung von Antworten. Dieser Prozess wird als Retrieval-Augmented Generation (RAG) bezeichnet. Der Vorteil: Die von LLMs generierten Antworten können auf ihre Quellen zurückverfolgt werden und liefern aktuelle, kontextuell relevante Fakten.

Im Folgenden beschreiben wir die einzelnen Komponenten eines LLM Assistenten sowie deren jeweilige Funktionsweise im Detail.

1. Large Language Model (LLM)

Das Sprachenmodell ist das Herzstück des LLM Assistenten welches Texteingaben (sogenannte Prompts) entgegennimmt, diese verarbeitet und Antworten generiert. Ein Prompt besteht dabei aus verschiedenen Bestandteilen. Unter anderem gehört dazu die Frage des Benutzers, der dazugehörige Kontext aus den unternehmenseigenen Dokumenten und eine System-Anweisung an das Sprachenmodell, welche zusätzliche Instruktionen liefert.

Die wohl bekanntesten Modelle sind aktuell OpenAIs GPT-3.5 und GPT-4. Die angebotenen APIs bieten einen hohen Komfort und beeindruckende Performance, ergänzt durch zahlreiche integrierte Funktionen. Zum Beispiel ermöglicht die neu vorgestellte Assistants API eine spannende Entwicklung: die Umsetzung von Agenten. Diese Agenten können durch Anweisungen und erweitertes Wissen mit anderen Modellen und Tools interagieren, um eigenständig Aufgaben zu erledigen. Jedoch wirft die Verwendung der OpenAI APIs oft Bedenken auf. Da es sich bei OpenAI um ein amerikanisches Unternehmen handelt und Daten verarbeitet werden stellt sich die Frage der Vereinbarkeit mit der Datenschutzgrundverordnung. Dazu schreibt OpenAI auf ihrer Webseite, dass die Schnittstelle zu Unternehmen den Vorgaben der DSGVO entsprechen. Es kann auch ein Auftragsverarbeitungsvertrag ausgestellt werde. Trotz allem: Inwiefern und in welcher Kapazität die an die API gesendeten Daten verarbeitet und gespeichert werden ist nicht transparent und kann nie komplett garantiert werden. Besonders bei sensitiven unternehmensinternen Daten stellt dies ein erhebliches Risiko dar. Zudem ist das Sprachenmodell nicht öffentlich zugänglich, wodurch eine Prozesstransparenz nicht gegeben ist.

Eine Alternative ist die Nutzung von Open-Source - also frei zugänglichen - Sprachenmodellen. Diese haben im Bezug auf Performance deutlich auf die Modelle von OpenAI aufgeholt. Besonders das von Meta entwickelte Llama2 Modell war die Grundlage für viele hoch performante Ableger-Modelle. Aber auch kleinere und kostengünstigere Modelle, wie Mistral-7B, verbessern sich stetig und reduzieren Hürden beim Einsatz von Sprachenmodellen.

Welches Large Language Model eignet sich am besten?

2. Datenspeicher

Dies beinhaltet alle klassischen Datenspeicherarten. Hier ist alles möglich, vom SharePoint mit unstrukturierten Daten wie PDFs, Word Dokumente und PowerPoint Präsentation bis zur klassischen relationalen Datenbank. Auch die interne Wissensdatenbanken und Texte im Intranet gehören zu diesen Datenformaten. Daten in diesen Speichern können genutzt werden, um dem Sprachenmodell den notwendigen Kontext zu liefern und damit eine Antwort zu generieren.

3. Vektordatenbank

Vektordatenbanken speichern unstrukturierte Daten wie z.B. Textdokumente aus den Datenspeichern in einem Format, das von einem Large Language Model verarbeitet werden kann. Im Gegensatz zu herkömmlichen Datenbanken, speichern Vektordatenbanken keine skalare Werte, sondern mehrdimensionale Datenpunkte (Vektoren). Dies ermöglicht es Daten in einem mehrdimensionalen Raum darzustellen, bei dem ähnliche Datenpunkte räumlich enger zusammen liegen. Eine solche Darstellung der Daten ist allgemein auch als Embedding bekannt. Im Kontext von natürlicher Sprache liegen somit Dokumente mit einer semantisch gleichen oder ähnlichen Bedeutung näher zusammen. Zum Beispiel ähneln sich zwei Text über Hunde eher als jeweils ein Text über ein Flugzeug und über einen Hund.

In der Praxis bedeutet dies, dass alle Dokumente aus einem Datenspeicher in viele kleine Bestandteile aufgeteilt werden und jeweils in ein Vektorformat übertragen werden. Anschließend werden alle Vektoren in einer Vektordatenbank abgespeichert, welches das Embedding darstellt. Für jeden Vektor in der Datenbank können zusätzlich Metadaten abgespeichert werden. Beispielsweise kann zusätzlich zur Antwort des LLM Assistenten über einen Dokumenten-Identifikator angegeben werden, aus welchen Quelldokumenten die Antwort generiert wurde.

Wird nun eine Anfrage von einem Benutzer gestellt, werden durch eine semantische Suche Dokumentteile aus der Vektordatenbank extrahiert die zu dem Kontext der Frage passen. Diese werden anschließend zusammen mit der Anfrage an das Sprachenmodell weiter gegeben, welches eine Antwort generiert.

Werkzeuge

Um all diese Komponenten zu verbinden haben sich zahlreiche auf Open-Source basierende Frameworks und Tools wie LangChain und LlamaIndex etabliert. Auch für die Implementierung von Agenten gibt es zahlreiche Frameworks, die eingesetzt werden können. Zudem besteht die Möglichkeit das Sprachenmodell einem Fine-Tuning zu unterziehen. Dabei wird das Sprachenmodell auf domänespezifischem Wissen trainiert, welches die Performance und Ausgabequalität steigern kann.

Anwendungsfelder

Den Anwendungsfeldern von “Chat With Your Docs” sind im Prinzip keine Grenzen gesetzt. Folgend führen wir einige Beispiele und Anwendungsgebiete auf.

1. Produkt Dokumentation

Ein Produkt wurde verkauft und das Training mit dem Kunden durchgeführt. Da Sie den Kunden nicht alleine lassen wollen, wird ihm eine Dokumentation an die Hand gegeben. Diese kann jedoch oft mehrere hundert Seiten umfassen. Mit Hilfe eines Chatbots kann ein Kunde Fragen zum Produkt stellen und der Chatbot liefert eine Antwort basierend auf der Produktdokumentation, kann aber zudem zusätzlichen Kontext liefern. Dies erhöht nicht nur die Kundenzufriedenheit, sondern erleichtert auch den Kundensupport, der sich auf nicht triviale Probleme fokusieren kann.

Ein Beispiel für solch ein Chat-Interface auf einer Dokumentation bietet das LangChain Framework. Auf der Dokumentationsseite kann man zwischen einer reinen Keyword-Textsuche oder einer Chat-basierten Suche entscheiden. Entwickler können hier Fragen zur Bibliothek und Implementierung stellen, sich Beispiele aufzeigen lassen und vieles mehr.

2. Kundensupport

Auch im Kundensupport kann ein Chatbot zur Anwendung kommen. Wendet sich ein Kunde an einen Kundensupport kann der Mitarbeiter im Support den Chatbot nutzen, um Probleme schneller identifizieren und lösen zu können. Der Chatbot kann interne Dokumentationen, Kundendetails oder sogar Maschienenkonfigurationen des Kunden durchsuchen und den Support bei der Problemlösung unterstützen. Dies erhöht die Effizienz und Effektivität des Kundensupports und steigert nebenbei auch noch die Kundenzufriedenheit.

3. Customer Feedback

Kundenfeedback erhält ein Unternehmen aus unterschiedlichsten Quellen, z.B. von Social Media, Kundenrezensionen oder durch Kundenzufriedenheitsumfragen. Diese auf Text basierten Daten können mit Hilfe eines Chatbots analysiert werden. So kann das Niveau der Kundenzufriedenheit und Kundenwünsche besser verstanden werden und Verbesserungsbereiche identifiziert werden. Außerdem können Bedenken direkt und umgehend angesprochen werden. Zudem kann dieser Chatbot nicht nur von einer Marketing-Abteilung genutzt werden, sondern Produktentwicklungsteams hätten ebenfalls die Möglichkeit direkt mit dem Kundenfeedback zu interagieren und darauf basierend Entscheidungen zu treffen.

4. Produktentwicklung

Die Einsatzmöglichkeiten in der Produktentwicklung sind ebenso vielfältig. Zum Beispiel können Produktmanager Marktanalysedokumente analysieren lassen um Produkttrends oder Kundenpräferenzen zu analysieren. Auch können Dokumentation von Wettbewerbern analysiert werden. Somit können Features und Performance mit den eigenen Produkten verglichen werden um Marktlücken zu identifizieren. In einem weiteren Anwendungsfall könnten Ingenieure Chatbots verwenden um Design-Spezifikationen zu durchforsten um sicher zu gehen, dass alle Kriterien und Standards eingehalten werden, bevor ein Produkt entwickelt wird. Der Chatbot könnte sogar als Assistent agieren und bei der Entwicklung von Produkten helfen.

5. Personalabteilung

In Personalabteilungen werden täglich zahlreiche Dokumente verwaltet und Informationen dokumentiert. Ein Chatbot könnte bei Fragen von Mitarbeitenden bezüglich Unternehmensrichtlinien oder Mitarbeitervorteilen behilflich sein. Diese können mit Hilfe eines Chatbots schneller bearbeitet werden, indem der Chatbot die entsprechenden Informationen für die Mitarbeitenden in der Personalabteilung herausssucht. Des Weiteren könnte ein Chat-Assistent Dokumente zu rechtlichen Vorschriften bei der Steuererklärung für Mitarbeitende durchsuchen.

6. Supply-Chain-Management

Im Supply-Chain-Management könnte ein Chatbot Fragen zu Verträgen, Vereinbarungen und Leistungsberichten beantworten und über Lieferantenbedingungen informieren und diese mit anderen Lieferanten vergleichen. Ein ähnlicher Anwendungsfall findet sich in der Qualitätskontrolle und -management. Der Assistent kann genutzt werden, um eine vielzahl an Qualitätsberichten und Kundenfeedback zu analysieren. Damit können Probleme und Trends in der Produktqualität effizienter identifiziert werden. Basierend darauf kann der Assistent Maßnahmen zur Verbesserung vorschlagen. Auch im Compliance-Management kann ein ein LLM Assistent helfen. Oft liegen sehr viele Dokumente zu Handels- und Zollvorschriften sowie Umwelt- und Sicherheitsstandards vor. Mit einem LLM Assistent lassen sich Vorschriften und Regelwerke schnell und effizient durchsuchen und zusammenfassen. Zudem kann eine Bewertung der Compliance-Risiken in verschiedenen Teilen der Lieferkette erfragt werden. Der LLM Assistent kann daraufhin ebenfalls Vorschläge zur Vermeidung von Verstößen generieren.

7. Management

Ein LLM Assistent im Management kann relevante Informationen aus einer Vielzahl von Quellen zusammenführen und aufbereiten, um Führungskräften bei der Eintscheidungsfindung zu helfen. So können mit wenigen Eingaben Ad-Hoc Analysen durchgefürt oder Reports erstellt werden. Mit Hilfe des LLM Assistenten können auch Szenarioanalysen durchgeführt werden um die Auswirkungen verschiedener Entscheidungen zu simulieren.

Maßnahmen

Damit ein effektiver, effizienter und sicherer Einsatz eines LLM Assistenten gewährleistet werden kann sind einige Dinge zu beachten, die wir im Folgenden betrachten.

Datenschutz und Sicherheit: Es ist entscheidend, dass die Nutzung des LLM Assistenten den Datenschutzgesetzen und -richtlinien entspricht, insbesondere wenn personenbezogene Daten verarbeitet werden. Zudem muss die Sicherheit der Daten gewährleistet werden, um Datenlecks und unerlaubte Zugriffe zu verhindern.

Datenqualität und -quellen: Die Qualität der vom LLM Assistenten gelieferten Ergebnisse hängt stark von der Qualität der verwendeten Daten ab. Es ist wichtig, sicherzustellen, dass die Datenquellen zuverlässig und aktuell sind.

Verständnis der Grenzen: LLM Assistenten sind fortschrittliche Tools, aber sie haben ihre Grenzen. Sie verstehen Kontext und Nuancen nicht immer perfekt und können fehleranfällig sein. Es ist wichtig, ihre Vorschläge und Analysen kritisch zu bewerten.

Integration in bestehende Systeme: Die Integration des LLM Assistenten in bestehende Unternehmenssysteme und -prozesse muss sorgfältig geplant werden, um einen reibungslosen Betrieb und maximale Effizienz zu gewährleisten. Sollte der LLM Assistent sogar soweit gehen, dass er eigenständig Aufgaben erfüllt, sollte trotz allem immer ein Mitarbeiter dahinter stehen, der diesen Prozess überwacht.

Ethische Überlegungen: Der Einsatz künstlicher Intelligenz wirft ethische Fragen auf, insbesondere im Hinblick auf Transparenz, Verantwortlichkeit und potenzielle Voreingenommenheit in Algorithmen. Diese Aspekte sollten sorgfältig berücksichtigt werden.

Regulatorische Compliance: Abhängig von der Branche und dem Anwendungsfall muss sichergestellt werden, dass die Nutzung von LLM Assistenten den relevanten gesetzlichen und regulatorischen Anforderungen entspricht.

Kontinuierliche Überwachung und Anpassung: Es ist wichtig, die Leistung des LLM Assistenten regelmäßig zu überwachen und Anpassungen vorzunehmen, um seine Effizienz und Genauigkeit zu verbessern.

Fazit

Die Technologie eines “Chat With Your Docs” Assistenten eröffnet zahlreiche Möglichkeiten, um Geschäftsprozesse zu optimieren und Mitarbeiter in ihrer Arbeit zu befähigen effizienter und effektiver Informationen zu verarbeiten. Aber nicht nur die Informationsverarbeitung ist ein enormer Vorteil, die Assistenten können auch Ideen generieren und somit Innovationen fördern. Die Implementierung solcher Systeme erfordert allerdings auch eine sorgfältige Beachtung von Datenschutz, Sicherheit, Datenqualität und regulatorischer Compliance. Ethische Überlegungen und ein Verständnis der Grenzen dieser Technologien sind ebenfalls unabdingbar. Trotz der potenziellen Herausforderungen ist das Potenzial der intelligenten Assistenten enorm. Sie sind nicht nur ein Schritt in Richtung einer effizienteren und intelligenteren Datenverarbeitung, sondern auch ein Beispiel dafür, wie künstliche Intelligenz die Landschaft der Unternehmenssoftware und -dienstleistungen revolutionieren kann.