Neue Forschungsergebnisse zur Anwendung von LLMs für den Verbraucherschutz im KIVEDU-Projekt

Inhaltsverzeichnis

Einleitung

Im Zeitalter der Digitalisierung steht der Schutz von Verbraucherrechten vor neuen Herausforderungen. Das KIVEDU-Projekt, initiiert von XPACE GmbH und der Pforzheim University, widmet sich dieser Aufgabe mit einem innovativen Ansatz: der Anwendung von Large Language Models (LLMs) zur Erkennung von Verstößen gegen Unterlassungserklärungen in deutschen Online-Produktbeschreibungen.

Sie möchten mehr über KIVEDU erfahren?

Besuchen Sie die ProjektseiteIm Rahmen der DataMod-Konferenz durften wir unsere Forschungsergebnisse zu diesem Thema präsentieren. Konkret ging es dabei um eine Untersuchung, welche LLMs am besten für die Erkennung von Verstößen gegen Unterlassungserklärungen geeignet sind und wie sich verschiedene Prompt-Varianten auf die Leistung der Modelle auswirken. In diesem Blog-Post fassen wir die wichtigsten Erkenntnisse unserer Forschung zusammen und diskutieren unsere Ergebnisse. Die vollständige Veröffentlichung finden Sie hier.

Hintergrund

Unterlassungserklärungen sind rechtliche Dokumente, die von Verbraucherschutzorganisationen gegen Unternehmen eingesetzt werden, die irreführende oder ungenaue Online-Produktbeschreibungen verwenden. Diese Erklärungen sind bindend und bei Verstößen drohen den Unternehmen Strafen.

Ein wesentliches Problem dabei ist, dass viele Verbraucherschutzorganisationen weder die Ressourcen noch die Zeit haben, die Einhaltung dieser Erklärungen im Internet manuell zu überprüfen. Die Überwachung erfordert das Durchlesen tausender Produktbeschreibungen und Unterlassungserklärungen, was ein zeitaufwendiger und komplexer Prozess ist.

Bei KIVEDU arbeiten wir an der Lösung dieses Problems, indem wir diese Verstöße mittels KI automatisch erkennen. Dies erfordert jedoch eine gutes Sprachverständnis und die Fähigkeit, kleine Unterschiede und Feinheiten im Text zu verstehen. Traditionelle maschinelle Lernmodelle stoßen hier an ihre Grenzen, da sie oft nicht in der Lage sind, die Nuancen der Sprache ausreichend zu erfassen und zudem von großen Datenmengen abhängig sind.

Hier kommen Large Language Models (LLMs) ins Spiel. Diese Modelle, die oft auf der Transformer-Architektur basieren, werden mit riesigen Textdaten aus dem Internet trainiert und können menschliche Sprache sehr gut verarbeiten und generieren. Sie zeichnen sich durch ihre Fähigkeit aus, komplexe Sprache zu verstehen und können für eine Vielzahl von Aufgaben eingesetzt werden, ohne dass spezifische Trainingsdaten für jede einzelne Aufgabe erforderlich sind.

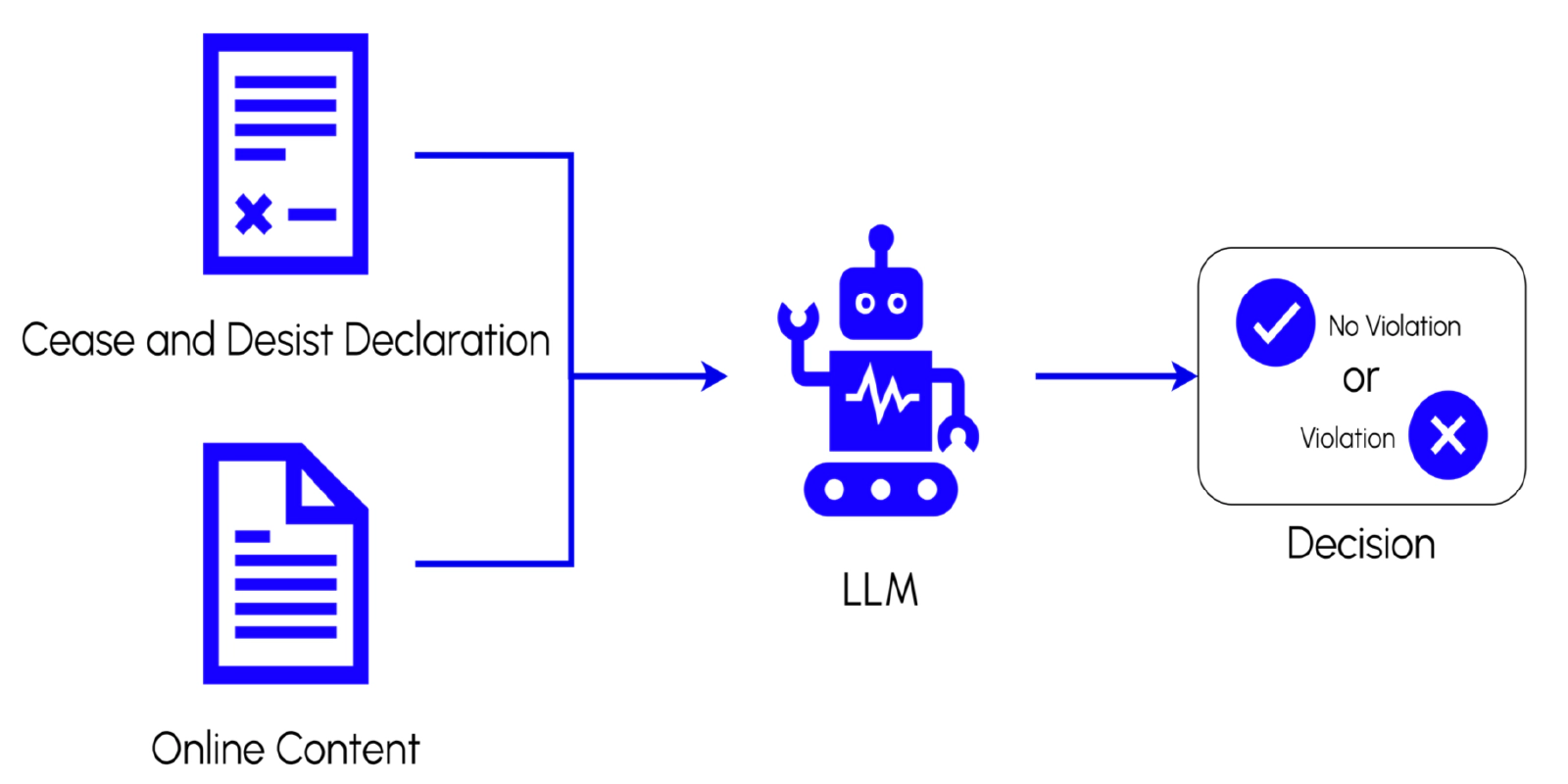

In unserer Forschung haben wir verschiedene LLMs auf die Aufgabe angewendet, Verstöße gegen Unterlassungserklärungen in deutschen Produktbeschreibungen zu identifizieren. Wir haben uns dabei insbesondere auf die ‘Zero-Shot-Prompting’-Methode konzentriert, bei der das Modell eine Anweisung und den Text der Unterlassungserklärung sowie der Produktbeschreibung erhält und dann entscheiden muss, ob ein Verstoß vorliegt. Dieser Ansatz ist recht simpel und kommt ohne die Erstellung großer Trainingsdatensätze aus, was typischerweise viel Zeit kostet. Dadurch eröffnet er neue Möglichkeiten, die Effizienz und Genauigkeit bei der Überwachung von Verbraucherschutzstandards zu verbessern.

Experiment

In unserer Studie haben wir fünf LLMs für diese Aufgabe getestet: zwei proprietäre Modelle von OpenAI (gpt-3.5-turbo-0301 und gpt-3.5-turbo-0613) sowie drei Open-Source-Modelle (LLaMA2, StableBeluga2 und Platypus2). Diese wurden auf einem Datensatz von 116 manuell gelabelten Paaren aus Unterlassungserklärungen und Produktbeschreibungen evaluiert, den wir mit Hilfe unserer Projektpartner erstellt haben. Wie bereits erwähnt, lag der Fokus darauf, zu ermitteln, welches Modell Verstöße am besten identifizieren kann und wie sich verschiedene Prompt-Varianten auf die Leistung der Modelle auswirken.

Zu diesem Zweck erstellten wir eine aus vier Komponenten bestehende Prompt-Struktur. Für jede Komponente entwarfen wir verschiedene Varianten, daraus ergaben sich insgesamt 72 verschiedene Prompts. Jeder Prompt wurde dann mit jedem Modell auf dem gesamten Datensatz evaluiert und miteinander verglichen.

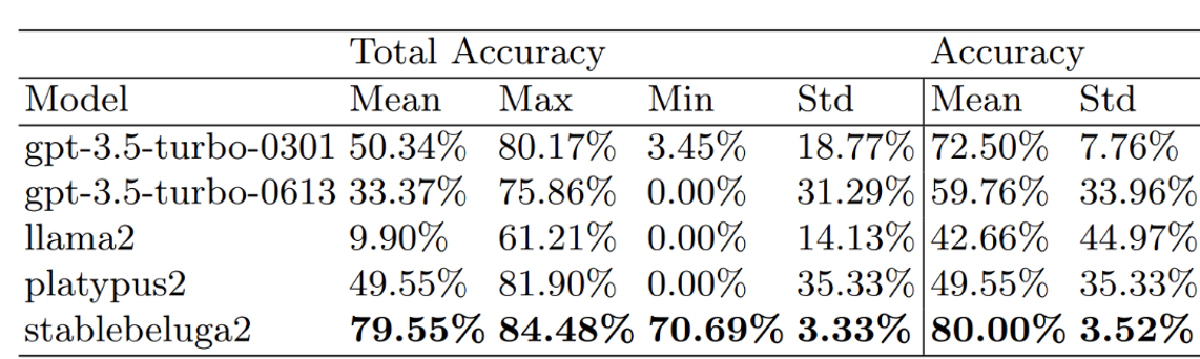

Für die Evaluation berechneten wir verschiedene Klassifikationsmetriken (Genauigkeit, Precision, Recall sowie F1-Werte). Bei diesen Metriken wurden jedoch nur die Beispiele berücksichtigt, für die das Modelle einen gültigen binären Output (also “1” oder “0” bzw. “Ja” oder “Nein” je nach Prompt) generierte. Zusätzlich berechneten wir noch die “Gesamtgenauigkeit”, die invalide Outputs als falsche Vorhersage wertet - diese Metrik ist dadurch für die Bewertung der Gesamtleistung der Modelle besser geeignet.

Erkenntnisse

Wir konnten auf Basis der erhobenen Daten aus den Experimenten folgende Erkenntnisse ziehen:

- StableBeluga2 zeigte sich als leistungsstärkstes Modell mit einer Gesamtgenauigkeit von 84,5 % auf der besten Prompt-Variante.

- Platypus2 und gpt-3.5-turbo-0301 folgten dicht dahinter, während gpt-3.5-turbo-0613 und LLaMA2 schlechter abschnitten. Interessant ist hierbei, dass das alte gpt-3.5-turbo-Modell deutlich besser abschnitt als das neue.

- StableBeluga2 wies über alle Varianten hinweg auch die höchste durchschnittliche Gesamtgenauigkeit auf.

- Die anderen Modelle zeigten eine niedrigere Durchschnittsleistung und eine hohe Varianz zwischen Varianten. Sie schnitten bei einigen Varianten sehr gut ab, bei anderen jedoch sehr schlecht.

Leistung der Prompt-Komponenten: Bei Betrachtung einzelner Prompt-Komponenten konnten wir folgende Erkenntnisse gewinnen:

- Die Anwendung von Role-Prompting (also die Zuweisung einer Rolle, wie bspw. Experte für Verbraucherschutz) führte zu keiner signifikanten Verbesserung oder Verschlechterung der Leistung.

- Der Einfluss der Verwendung einer detaillierten Schritt-für-Schritt-Anleitung für die Problemlösung im Prompt stark abhängig vom Modell. Während Platypus2 die beste Leistung ohne eine solche Komponente erzielte, profitierten die anderen Modelle von dadurch.

- Die Verwendung eines “Ja”/“Nein” Ausgabeformats war über alle Modelle hinweg die beste Option. Je nach Modell war die Leistung bei der Verwendung eines numerischen oder semantischen Formats jedoch besser.

Sie finden detaillierte Auswertungen zu den einzelnen Modellen und Prompt-Varianten in unserem Online-Repository auf GitHub.

Die Studie liefert wichtige Erkenntnisse über die Leistungsfähigkeit verschiedener Sprachmodelle und die Auswirkungen verschiedener Prompt-Komponenten auf diese Leistung.

Abschluss

LLMs stellen eine vielversprechende Lösung für die Automatisierung der Erkennung von Verstößen gegen Unterlassungserklärungen in deutschen Online-Produktbeschreibungen dar. Unsere Forschung zeigt, dass die Wahl des richtigen Modells und die sorgfältige Gestaltung von Prompts entscheidend sind, um eine hohe Genauigkeit bei dieser Aufgabe zu erreichen.

Wir sind überzeugt, dass diese Erkenntnisse nicht nur für unser KIVEDU-Projekt, sondern auch für die breitere Gemeinschaft von Forschern, Entwicklern und Verbraucherschutzorganisationen von Bedeutung sind. Indem wir die Potenziale und Grenzen von LLMs besser verstehen, können wir effektive Lösungen entwickeln, die den Schutz von Verbraucherrechten in der digitalen Welt stärken.