AI und LLM Agents: So funktionieren intelligente KI-Assistenten wirklich

Inhaltsverzeichnis

Große Sprachmodelle (Large Language Models, LLMs) haben sich in den letzten Jahren stark weiterentwickelt. Von einfachen Chatbots, die auf einzelne Anfragen reagieren, hin zu komplexen Systemen, die autonom handeln können. Heute beschäftigen wir uns ausführlich mit sogenannten „LLM Agents“, die nicht nur antworten, sondern aktiv Probleme lösen können, indem sie planen, externe Werkzeuge nutzen und ihre Vorgehensweise ständig verbessern.

Was genau sind eigentlich AI und LLM Agents?

Im Gegensatz zu normalen Chatbots, die einfache Antworten auf Fragen geben, können AI-Agents komplexe Ziele erkennen, diese in kleinere Teilprobleme zerlegen und selbstständig externe Tools nutzen. Sie passen ihre Strategie laufend an, was sie deutlich flexibler und leistungsfähiger macht. Dabei lösen sie einige der klassischen Schwächen normaler Sprachmodelle wie fehlendes Langzeitgedächtnis oder fehlende Echtzeit-Informationen. Typische Anwendungsfälle sind persönliche Assistenten, automatisierte Recherche oder autonome Entscheidungen in komplexen Umgebungen.

Wie ist ein LLM Agent aufgebaut?

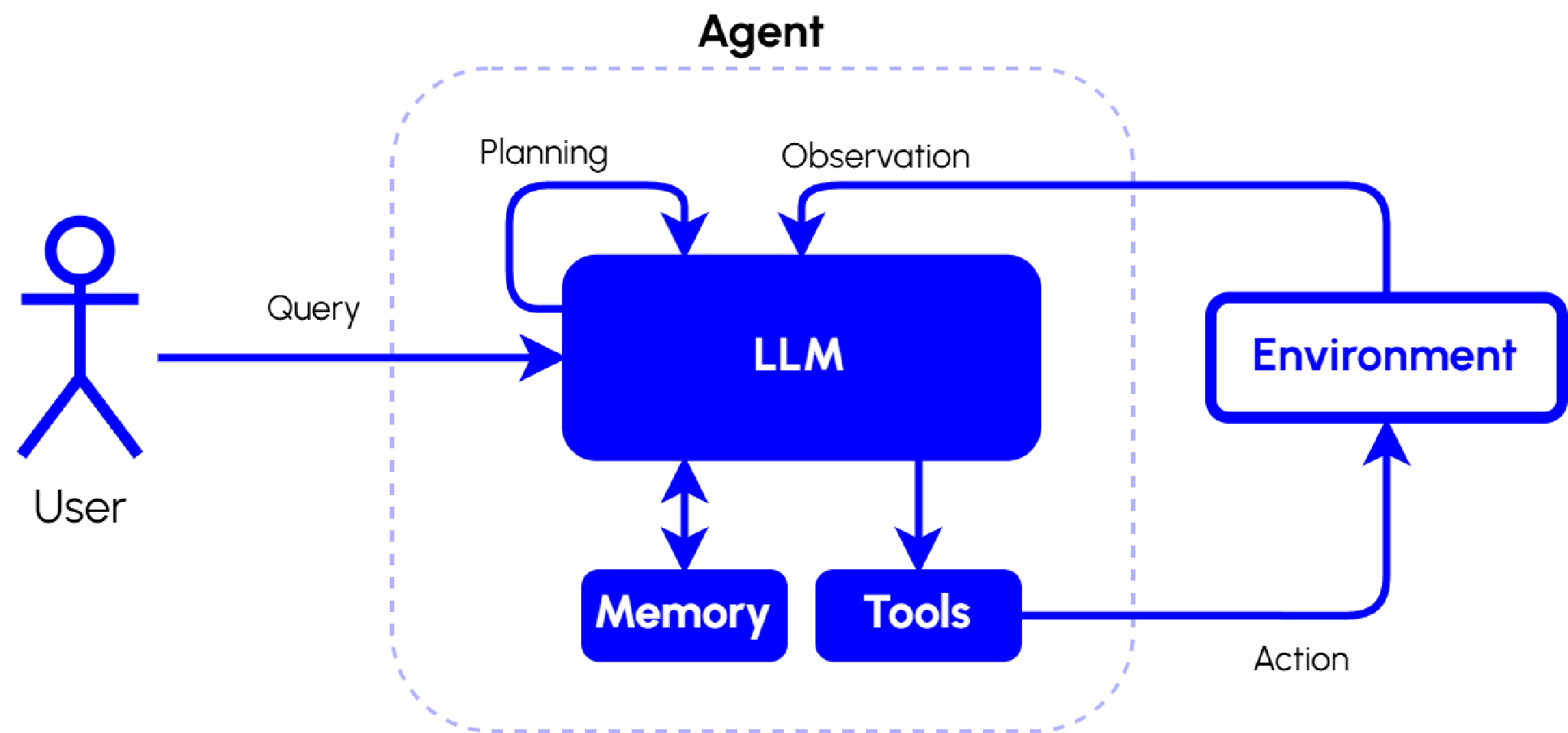

Ein typischer LLM Agent besteht aus mehreren Komponenten, die in enger Abstimmung zusammenarbeiten, um Nutzeranfragen effektiv und zielgerichtet zu beantworten. Das Zusammenspiel dieser Komponenten lässt sich folgendermaßen beschreiben:

-

Nutzeranfrage (Query): Ausgangspunkt ist stets die Anfrage oder Aufgabe des Nutzers. Diese wird direkt an das zentrale Sprachmodell (LLM) übergeben.

-

LLM (Agent-Gehirn): Das Herzstück des Agenten, ein großes Sprachmodell, analysiert die Nutzeranfrage, interpretiert sie und entscheidet über die nächsten Schritte. Dabei verarbeitet es verschiedene Eingaben und entscheidet, ob externe Tools genutzt, Informationen gespeichert oder direkte Antworten generiert werden sollen.

-

Planungsmodul (Planning): Das LLM teilt komplexe Aufgaben in kleinere, handhabbare Einzelschritte auf, um den Lösungsprozess besser zu strukturieren. Das erleichtert insbesondere bei umfangreichen oder vielschichtigen Anfragen eine systematische Bearbeitung.

-

Tool-Schnittstellen (Tools): Der Agent nutzt externe Dienste wie APIs, Datenbanken, Websuche oder andere Werkzeuge, um fehlende oder ergänzende Informationen aus der Umgebung („Environment“) zu beziehen. Der Agent sendet Aktionen (Action) an diese externe Umgebung, erhält Beobachtungen (Observation) zurück und verarbeitet diese, um präzisere und aktuellere Antworten zu generieren.

-

Gedächtnisspeicher (Memory): Das LLM kann wichtige Informationen oder Ergebnisse aus vorherigen Schritten abspeichern, um Kontext über längere Interaktionen hinweg zu bewahren und kontinuierlich verbesserte Entscheidungen zu treffen.

-

Environment: Die externe Umgebung, mit der der Agent interagiert, stellt ihm relevante Informationen bereit. Diese Interaktion erfolgt über Aktionen (Action) des Agenten und entsprechende Rückmeldungen (Observation) der Umgebung.

-

Reflexionsmechanismus (optional): In einigen Agenten kann zusätzlich ein Reflexionsmechanismus integriert sein, der es ermöglicht, die bisherigen Entscheidungen des Agenten kritisch zu bewerten und gegebenenfalls zu korrigieren, um zukünftige Entscheidungen kontinuierlich zu verbessern.

Diese Teile arbeiten eng zusammen: Der Agent bekommt eine Anfrage, erstellt daraus einen Plan, nutzt Tools, verarbeitet die Ergebnisse und lernt ständig dazu. Dabei kann der Ablauf dynamisch angepasst werden, je nachdem welche Ergebnisse gerade vorliegen. So entstehen iterative Zyklen aus Aktion und Reflexion, die Agenten besonders effektiv machen.

Planen und Ausführen – wie Agents vorgehen

Agenten nutzen unterschiedliche Strategien, um Aufgaben zu lösen:

Schrittweises Denken (Chain-of-Thought)

Dabei zerlegt der Agent ein Problem vor der Ausführung in klare, einzelne Schritte. Das ist zwar intuitiv, kann aber zu Problemen führen, wenn sich während der Ausführung des Plans die Rahmenbedingungen ändern oder unerwartete Hindernisse aufkommen.

Baumartiges Denken (Tree-of-Thoughts)

Hier verfolgt der Agent mehrere Lösungswege gleichzeitig, vergleicht sie miteinander und passt die Strategie bei Bedarf an. Das ist besonders bei komplexen Aufgaben effektiv und reduziert das Risiko, auf dem falschen Weg stecken zu bleiben.

ReAct – Flexibles Planen und Handeln

Bei ReAct erstellt der Agent nicht den kompletten Plan vorab, sondern reagiert ständig auf Zwischenergebnisse. So bleibt er flexibel, reduziert Fehler und kommt besser mit Überraschungen zurecht. Ergänzend dazu gibt es Reflexionstechniken, die durch selbstkritisches Hinterfragen die Lösung noch weiter verbessern.

Tools und Interaktion mit der Außenwelt

Ein großer Vorteil von LLM Agents ist ihre Fähigkeit, externe Werkzeuge effektiv zu nutzen. Sie kommunizieren dabei beispielsweise mit Webservices oder Datenbanken, um fehlendes Wissen auszugleichen oder exaktere Ergebnisse zu erzielen. Wichtig ist dabei, dass diese Interaktionen sicher und kontrolliert stattfinden, um Fehler und Risiken zu vermeiden. Typische Tools umfassen Web-Suchmaschinen, Code-Interpreter, Rechner und sogar Steuerungssysteme für physische Geräte.

Zusammenarbeit von mehreren Agents

Besonders spannend ist es, wenn mehrere spezialisierte Agents gemeinsam an Aufgaben arbeiten:

- Orchestrator-Worker-Modell: Ein Agent verteilt Aufgaben, die andere Agenten lösen. Die Ergebnisse werden dann vom Orchestrator zusammengeführt und bewertet. Diese Struktur erlaubt paralleles Arbeiten und effizientes Lösen komplexer Aufgaben.

- Evaluator-Optimizer (Critic-Actor): Ein Agent erstellt Lösungen, ein zweiter bewertet diese kritisch. So verbessert sich die Qualität durch ständiges Feedback, und Fehler können frühzeitig erkannt und korrigiert werden.

Bei der Zusammenarbeit mehrerer Agents muss aber auf klare Kommunikation und Koordination geachtet werden, da Fehler sonst leicht vervielfältigt werden können. Vertrauen, Validierung und gute Schnittstellen sind essenziell für erfolgreiche Multi-Agent-Systeme.

Wie bewertet man eigentlich LLM Agents?

Agenten richtig zu bewerten ist nicht trivial. Es reicht nicht nur aus zu prüfen, ob eine Aufgabe gelöst wurde – man muss auch die einzelnen Schritte und die Nutzung der Tools bewerten:

- Aufgabenerfolg und Effizienz: Misst die Qualität und Geschwindigkeit der Lösung.

- Transparenz und Qualität des Prozesses: Bewertet die einzelnen Entscheidungen und Schritte.

- Menschliche Bewertung: Ergänzt automatische Tests durch menschliche Einschätzungen der Hilfsbereitschaft und Verständlichkeit.

- Robustheit und Generalisierung: Prüft, ob der Agent auch in unterschiedlichen Situationen zuverlässig arbeitet.

- Interaktive Evaluierung: Betrachtet zusätzlich die Interaktion zwischen Agent und Nutzer und bewertet, wie sinnvoll und nutzerfreundlich die Lösungen sind.

Tests wie AgentBench, ALFWorld oder WebShop bieten hierfür realistische Szenarien und Vergleichsmöglichkeiten, um die Fähigkeiten der Agenten umfassend und unter praxisnahen Bedingungen zu evaluieren.

Sie möchten Agenten in Ihrem Unternehmen einsetzen? Dann kommen Sie gerne auf uns zu.

Jetzt kontaktierenFazit – und wie es weitergeht

LLM Agents sind ein großer Schritt nach vorne, wenn es darum geht, komplexe Probleme mit KI zu lösen. Durch Planung, Nutzung externer Tools und Zusammenarbeit werden sie immer leistungsfähiger. Trotzdem gibt es noch Herausforderungen, beispielsweise bei langen und unvorhersehbaren Aufgaben oder ethischen Fragestellungen.

In Zukunft werden vor allem bessere Gedächtnis- und Logiksysteme sowie multimodale Fähigkeiten – wie die Verarbeitung von Bildern oder Sprache – wichtig. Langfristig könnten ganze Netzwerke von Agents entstehen, die ähnlich wie Menschen zusammenarbeiten, Aufgaben verteilen und gemeinsam Lösungen entwickeln.