Retrieval-Augmented Generation (RAG): Faktenwissen für Sprachmodelle

Inhaltsverzeichnis

In den letzten Jahren haben Large Language Models (LLMs) beeindruckende Fortschritte in der Textgenerierung gemacht. Sie erzeugen Texte, die oft kaum von menschlichen geschriebenen zu unterscheiden sind. Doch trotz dieser Fähigkeiten kämpfen Sprachmodelle mit einer entscheidenden Schwäche: der faktischen Genauigkeit ihrer Antworten. Oft produzieren sie überzeugende, aber falsche oder veraltete Informationen – ein Phänomen, das als „Konfabulation“ oder „Halluzination“ bezeichnet wird. Eine vielversprechende Lösung hierfür bietet Retrieval-Augmented Generation, kurz RAG.

Was genau ist Retrieval-Augmented Generation (RAG)?

Retrieval-Augmented Generation kombiniert Sprachmodelle mit externen Wissensquellen, um die Qualität und Genauigkeit der generierten Antworten zu verbessern. Statt ausschließlich auf ihr internes, während des Trainings gelerntes Wissen zuzugreifen, greifen RAG-Systeme zusätzlich auf eine externe Wissensdatenbank zu, die relevante Fakten oder Dokumente liefert, um fundierte und korrekte Antworten zu generieren.

Wie funktioniert RAG?

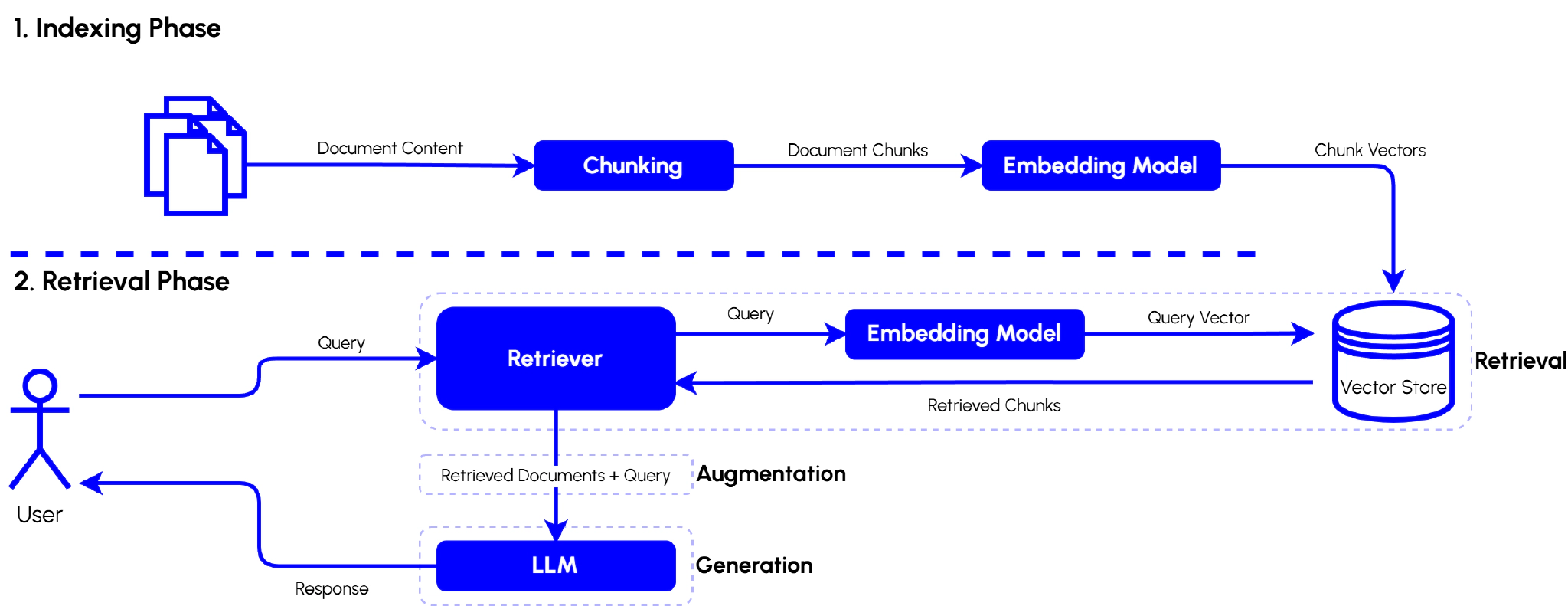

Ein Retrieval-Augmented Generation (RAG)-System nutzt zwei Hauptphasen: die Retrieval-Phase, in der Informationen gezielt abgerufen und Antworten generiert werden, sowie die vorbereitende Indexing-Phase, welche die Grundlage für eine effiziente Informationsabfrage legt.

Indexing-Phase

In der Indexing-Phase werden die Inhalte so aufbereitet, dass sie später effizient durchsucht werden können. Sie besteht aus folgenden Schritten:

- Chunking: Vorhandene Dokumente werden in kleinere, semantisch sinnvolle Abschnitte („Chunks“) zerlegt, um später eine präzisere Informationsabfrage zu ermöglichen.

- Embedding: Diese Chunks werden anschließend mithilfe eines Embedding-Modells in semantische Vektorrepräsentationen überführt.

- Speicherung: Die entstandenen Vektorrepräsentationen werden schließlich in einer Vektordatenbank („Vector Store“) gespeichert und indexiert. Dadurch wird sichergestellt, dass der Retriever später schnell und präzise relevante Informationen abrufen kann.

Die Effektivität der späteren Antwortgenerierung (Retrieval) hängt wesentlich von der Qualität der Indexierung ab.

Retrieval-Phase

Die Retrieval-Phase setzt sich aus zwei zentralen Schritten zusammen:

Retrieval-Step (Augmentation)

- Anfrage des Nutzers: Der Nutzer stellt eine Anfrage an das System.

- Semantic Similarity Suche: Die Nutzeranfrage wird mithilfe eines Embedding-Modells in einen semantischen Vektor („Query Vector“) übersetzt.

- Retriever: Dieser Query Vector wird genutzt, um in der vorbereiteten Vektordatenbank nach semantisch ähnlichen, relevanten Textabschnitten („Chunks“) zu suchen. Diese Textabschnitte dienen als Kontextinformationen und werden der ursprünglichen Nutzeranfrage hinzugefügt.

Generations-Step (Generation)

- Die abgerufenen Textabschnitte sowie die ursprüngliche Nutzeranfrage („augmentierte Anfrage“) werden an ein generatives Sprachmodell (LLM) übergeben.

- Das LLM erzeugt auf Grundlage dieser zusätzlichen Kontextinformationen eine faktenbasierte und relevante Antwort, welche schließlich dem Nutzer zurückgegeben wird.

Beispiel: Wenn ein Nutzer fragt „Was ist die Hauptstadt des Landes, das 2018 die Fußball-WM gewonnen hat?“, werden durch den Retriever zunächst relevante Dokumente gefunden (z.B. „Frankreich gewann 2018 die WM“ und „Die Hauptstadt Frankreichs ist Paris“). Anschließend generiert das LLM daraus die Antwort: „Die Hauptstadt von Frankreich, dem Gewinner der Fußball-WM 2018, ist Paris.“

Warum ist RAG so wichtig?

RAG adressiert eine zentrale Herausforderung klassischer Sprachmodelle: Aktualität und faktische Korrektheit. Da herkömmliche LLMs ihr Wissen ausschließlich aus ihren Trainingsdaten beziehen, können ihre Antworten veraltet oder falsch sein. RAG-Systeme hingegen können auf aktuelle und verifizierbare externe Quellen zugreifen, was:

-

Aktualität verbessert: Neue Informationen, wie etwa tagesaktuelle Ereignisse oder Veränderungen in rechtlichen Vorschriften, können unmittelbar integriert werden. Dadurch sind Antworten nicht nur genauer, sondern auch wesentlich relevanter für aktuelle Fragestellungen.

-

Halluzinationen reduziert: Die Antwortgenerierung stützt sich auf dokumentierte, nachvollziehbare Informationen, wodurch falsche oder erfundene Inhalte reduziert werden. Dies ist insbesondere in regulierten Bereichen wie Medizin, Recht oder Finanzen entscheidend.

-

Skalierbarkeit erhöht: Kleinere Modelle können dank der Anbindung an umfangreiche externe Wissensdatenbanken hochwertige und präzise Antworten liefern, ohne dass extrem große Modelle trainiert werden müssen. Dies reduziert Kosten und Ressourcenverbrauch und ermöglicht den Einsatz auf vielfältigen Plattformen.

-

Firmeninternes Wissen nutzbar macht: RAG kann interne Quellen (bspw. Dokumente, Wikis, Handbücher oder Ticketsysteme) in den Antwortprozess integrieren – ohne dass diese Daten in das Modell selbst einfließen müssen. Dadurch bleiben sensible Informationen sicher und dennoch effektiv nutzbar für Support, interne Suche oder Entscheidungsprozesse.

Zusätzlich verbessern RAG-Systeme die Transparenz und Nachvollziehbarkeit der generierten Antworten, da Nutzer die Quellen direkt überprüfen können. Dies erhöht das Nutzervertrauen und ermöglicht auch einen Einsatz in regulierten Umgebungen, in denen Nachvollziehbarkeit ein wesentliches Kriterium ist. Insgesamt steigert RAG somit sowohl die Nutzerzufriedenheit als auch die Praxistauglichkeit von Sprachmodellen signifikant.

Evaluierung von RAG-Systemen

Die Evaluierung von RAG-Systemen erfordert eine ganzheitliche Betrachtung, da sowohl die Qualität der abgerufenen Informationen als auch der generierten Antworten bewertet werden muss. Folgende Aspekte spielen dabei eine Rolle:

Retrieval-Performance

Diese misst, wie gut relevante Dokumente gefunden werden. Häufig verwendete Metriken sind:

- Recall@K: Gibt an, ob die relevanten Informationen in den obersten K Suchergebnissen enthalten sind. Ein hoher Recall bedeutet, dass kaum relevante Dokumente übersehen werden. Das ist besonders wichtig in Szenarien, in denen Vollständigkeit entscheidend ist, wie etwa bei medizinischen oder rechtlichen Fragestellungen.

- Precision@K: Beschreibt, welcher Anteil der Top-K-Ergebnisse tatsächlich relevant ist. Eine hohe Präzision reduziert den Aufwand für den Nutzer, da weniger irrelevante Inhalte manuell geprüft werden müssen.

- Mean Reciprocal Rank (MRR): Zeigt an, wie weit oben das erste relevante Dokument erscheint. Ein hoher MRR-Wert signalisiert, dass Nutzer häufig schon im ersten Treffer eine brauchbare Antwort erhalten, was die Nutzbarkeit und Zufriedenheit stark erhöht.

Generationsqualität

Hierbei geht es darum, wie gut die generierte Antwort zur Referenzantwort passt. Typische Metriken sind:

- Exact Match und F1-Score: Prüfen, wie exakt die generierte Antwort der Referenz entspricht. Während der Exact Match nur vollständige Übereinstimmungen berücksichtigt, erlaubt der F1-Score auch teilweise Überlappungen und gibt daher ein nuancierteres Bild der Antwortqualität.

- ROUGE, BLEU und BERTScore: Diese Metriken bewerten unterschiedliche Aspekte der Ähnlichkeit zwischen generierten und erwarteten Antworten. ROUGE fokussiert auf gemeinsame Wortgruppen (N-Gramme), BLEU ist besonders verbreitet bei Übersetzungs- oder textgenerierenden Aufgaben und bewertet syntaktische Ähnlichkeit, während BERTScore semantische Ähnlichkeit mithilfe von neuronalen Sprachmodellen quantifiziert.

Faktentreue und Verlässlichkeit

Diese Kategorie bewertet, ob die generierten Antworten tatsächlich auf den abgerufenen Dokumenten basieren – und nicht lediglich korrekt sind, aber aus anderen Quellen stammen. Hilfreiche Methoden sind:

- Manuelle Annotation: Experten oder geschulte Annotatoren überprüfen stichprobenartig, ob generierte Antworten den Quellen korrekt entsprechen. Diese Methode ist präzise, aber auch zeitaufwendig und kostspielig.

- Automatische Faktüberprüfungen: Einsatz automatischer Prüfverfahren, etwa auf Basis von externen Wissensdatenbanken oder spezialisierten Modellen, um die inhaltliche Korrektheit schnell und großflächig zu prüfen.

- Messung der Halluzinationsrate: Ermittelt, wie häufig ein Modell Fakten „erfindet“, die nicht durch Quellen gedeckt sind. Eine niedrige Halluzinationsrate ist wesentlich, um das Vertrauen der Nutzer zu erhalten, insbesondere in kritischen Anwendungsfeldern wie Gesundheit, Recht oder Finanzdienstleistungen.

End-to-End-Performance

Praktische Anwendungen wie FAQ-Systeme oder Wissensassistenten verlangen eine Gesamtevaluierung, welche die Interaktion von Retrieval und Generation berücksichtigt:

- Gesamtgenauigkeit: Misst, wie häufig Endnutzer auf Anhieb korrekte Antworten erhalten, unter realistischen Nutzungsszenarien. Dies ist entscheidend, um die Effektivität des Gesamtsystems in der Praxis zu beurteilen.

- Verifizierbarkeit der Antworten: Betrachtet, ob Nutzer einfach nachvollziehen können, auf welcher Grundlage Antworten generiert wurden. Gut nachvollziehbare Antworten erhöhen das Vertrauen und ermöglichen es Nutzern, eigenständig Antworten zu validieren.

- Benutzerfreundlichkeit und Konsistenz: Erfasst, wie einfach und angenehm Nutzer mit dem System interagieren können. Konsistenz und intuitive Gestaltung der Antworten tragen wesentlich dazu bei, die Nutzerakzeptanz und langfristige Nutzung zu sichern.

Effizienz und Latenz

Schließlich spielt auch die Performance eine Rolle, insbesondere in produktiven Systemen:

- Antwortzeit: Bewertet, wie schnell eine Anfrage von der Eingabe bis zur vollständigen Antwort generiert und zurückgegeben wird. Kürzere Antwortzeiten steigern die Nutzerzufriedenheit erheblich, insbesondere in interaktiven Anwendungen.

- Durchsatz: Gibt an, wie viele Nutzeranfragen gleichzeitig verarbeitet werden können. Ein hoher Durchsatz ermöglicht Skalierbarkeit und ist entscheidend, um auch bei großen Nutzerzahlen oder Lastspitzen zuverlässige Performance zu gewährleisten.

Vor- und Nachteile von RAG

Wie jedes System bringt RAG sowohl Stärken als auch Schwächen mit sich:

Vorteile:

-

Präzisere Antworten: Durch die gezielte Abfrage relevanter Dokumente können RAG-Systeme Antworten generieren, die genauer auf die konkrete Nutzeranfrage zugeschnitten sind. Dies erhöht die Relevanz und verbessert somit die Nutzerzufriedenheit.

-

Reduzierung von Halluzinationen: Da Antworten auf Grundlage tatsächlicher Inhalte generiert werden, reduziert RAG das Risiko, dass das Modell Fakten frei erfindet („halluziniert“). Dies ist besonders entscheidend bei regulierten Anwendungsbereichen.

-

Möglichkeit zur Integration aktueller Informationen: Im Gegensatz zu rein generativen Modellen, die nur auf statischen Trainingsdaten basieren, erlaubt RAG den Zugriff auf externe, jederzeit aktualisierbare Informationsquellen. Dadurch können aktuelle Inhalte verlässlich in die generierte Antwort einfließen.

Nachteile:

-

Höherer Implementierungsaufwand durch die Integration mehrerer Komponenten: Ein RAG-System umfasst sowohl ein Retrieval-Modul als auch ein generatives Sprachmodell. Der Aufwand für die Entwicklung, Wartung und Feinabstimmung dieser Komponenten ist höher und erfordert entsprechende technische Expertise.

-

Abhängigkeit von der Qualität der Wissensquelle: Die Genauigkeit der generierten Antworten hängt stark davon ab, wie aktuell, vollständig und verlässlich die zugrunde liegenden Daten sind. Fehlerhafte oder lückenhafte Inhalte führen zu ungenauen Ergebnissen – regelmäßige Pflege und Qualitätskontrollen sind daher essenziell.

-

Erhöhte Antwortzeit durch Retrieval-Phase: Der zusätzliche Schritt des Dokumentabrufs kann die Reaktionszeit im Vergleich zu rein generativen Modellen verlängern. Besonders in Echtzeitanwendungen, bei denen schnelle Antworten entscheidend sind, kann dies die Nutzererfahrung beeinträchtigen.

Sie möchten ein eigenes RAG-System in Ihrem Unternehmen einsetzen? Dann kommen Sie gerne auf uns zu.

Jetzt kontaktierenFazit

Retrieval-Augmented Generation (RAG) stellt einen wichtigen Fortschritt hin zu faktenbasierten und verlässlichen Sprachmodellen dar. Durch die Kombination von Wissensabruf und Textgenerierung lassen sich typische Schwächen klassischer, generativer KI-Systeme – wie Halluzinationen und mangelnde Aktualität – deutlich verringern. Trotz des erhöhten Aufwands bei Konzeption und Umsetzung lohnt sich der Einsatz von RAG insbesondere in Anwendungsfeldern, in denen Genauigkeit und Aktualität entscheidend sind.

Angesichts der rasanten Fortschritte bei KI und Sprachmodellen dürfte Retrieval-Augmented Generation weiter an Bedeutung gewinnen – und sich mittelfristig als Standard bei der Entwicklung anspruchsvoller KI-Systeme etablieren.